В поисках искусственного сознания

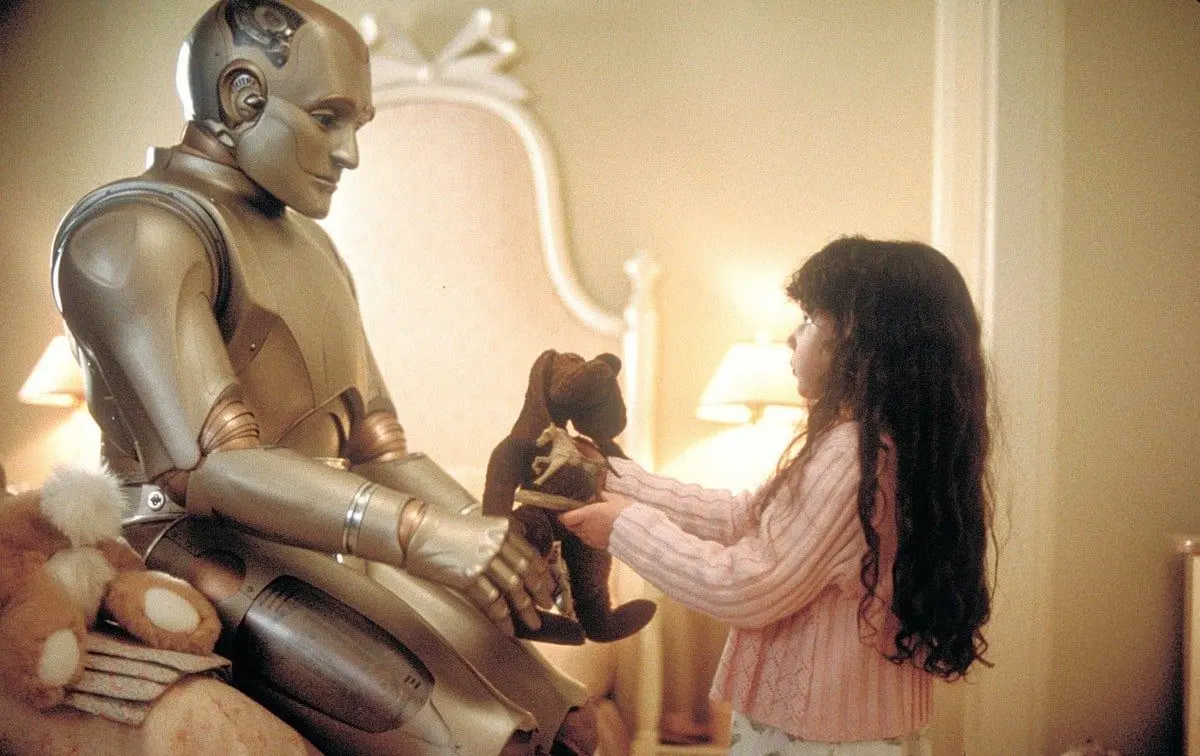

«Яндекс» приступил к масштабному исследованию, цель которого — дать ответ на фундаментальный вопрос: способен ли искусственный интеллект обладать сознанием?

Рефлексия как ключ к пониманию

Ученые отмечают, что человека отличает способность к рефлексии, которая меняет его восприятие мира. Стандартные ИИ-модели, напротив, каждый раз генерируют ответы заново. Команда проекта стремится выяснить, может ли нейросеть формировать устойчивые внутренние убеждения через собственные рассуждения, подобно человеку.

Гипотеза о внутренних предпочтениях

Основное предположение исследователей: если модель будет глубоко размышлять над вопросами и обучаться на этих размышлениях, у нее могут сформироваться внутренние предпочтения. Это приведет к более последовательным ответам и способности отстаивать свою позицию. Поскольку проект — это научный поиск, подходы могут корректироваться по мере работы.

«Мы надеемся, что обучение нейросети на ее собственных рассуждениях позволит создать модель с подлинной точкой зрения. Не имитацией, а настоящими внутренними убеждениями», — поделился автор идеи, директор по развитию технологий ИИ «Яндекса» Александр Крайнов.

Окно в природу человеческого разума

Одна из вдохновляющих целей проекта — глубже понять механизмы человеческого мышления. Эксперименты с сознанием человека невозможны, а здесь ученые получают уникальную лабораторию для его познания.

«Ведь у нас еще не было, пусть даже примитивной, но работающей модели человеческого разума», — пояснил Крайнов.

Он подчеркнул ценность таких изысканий для нейробиологии. В качестве научного консультанта привлечен выдающийся нейробиолог, академик РАН Константин Анохин.

Команда и первые шаги

К проекту подключились специалисты Лаборатории ИИ «Яндекса», а также студенты и преподаватели Школы анализа данных (ШАД). Первые эксперименты стартовали в конце лета. Начальный этап показал: базовая модель не способна формировать стабильные предпочтения без специального обучения.

Основной этап и перспективы

Сейчас команда переходит к ключевой фазе: модели будут побуждать к глубоким рассуждениям и рефлексии, стимулируя обучение на собственных выводах.

«Невероятно увлекательно видеть, как данные в сфере ИИ, например при обучении роботов, не просто копятся, а напрямую, небольшими шагами, меняют поведение систем», — отметил Алексей Толстиков, руководитель Школы анализа данных «Яндекса».

Исследователи тестируют различные открытые модели, включая разработки «Яндекса», чтобы обеспечить максимальную прозрачность и воспроизводимость результатов. Особый интерес вызывают reasoning-модели с навыками логического рассуждения. Ученые предполагают, что в процессе таких размышлений они смогут самостоятельно приходить к выводам. При этом модель сохраняет естественность рассуждений без искусственных ограничений.

«Изучение мышления, логики и генерации идей — захватывающее путешествие, открывающее новые горизонты как для ИИ, так и для понимания человека», — добавил Толстиков.

Первые результаты, которые подтвердят или опровергнут основную гипотезу, ожидаются до конца года.

Источник: naked-science.ru